Die Zukunft der industriellen Fertigung liegt in der nahtlosen Verknüpfung von Produktionsprozessen mit den neuesten Informations- und Kommunikationstechnologien. Ein wegweisendes Beispiel dafür ist das 2021 abgeschlossene Förderprojekt mit dem Titel "Wafer 4.0 – Herstellung von Kristallen und Wafern in einer Industrie 4.0-Umgebung". In diesem ambitionierten Projekt forschte Kontron AIS gemeinsam mit drei weiteren Partnern intensiv, um die Schnittstelle zwischen industrieller Fertigung und modernster Technologie zu optimieren.

Partner:

Fraunhofer CSP Institut

PVA Crystal Growing Systems GmbH

PV Crystalox Solar Silicon GmbH

Laufzeit: 01.07.2018 - 30.06.2021

Das Hauptziel: Verbindung von Produktion und Informationstechnologie

Um mithilfe selbstoptimierender Produktionsanlagen Kosteneinsparungen zu realisieren, zielte das Projekt auf die Intensivierung der Verknüpfung zwischen industrieller Fertigung und Informations- und Kommunikationstechnologien. Kontron AIS strebte dafür eine Symbiose zwischen traditionellen Prozessen der Kristall- und Waferfertigung und modernsten Technologien der Industrie 4.0 an. Das übergeordnete Ziel lag nicht nur im Erreichen technologischen Fortschritts, sondern auch in der signifikanten Verbesserung der Wirtschaftlichkeit der Produktion.

Dazu wurden klare Teilziele definiert:

- Senkung der Stromgestehungskosten (LCOE): Die Entwicklung selbstoptimierender Produktionsanlagen zielt darauf ab, die Stromgestehungskosten für eine Photovoltaikanlage in Süddeutschland auf unter 5 Cent pro Kilowattstunde zu senken. Damit soll nicht nur die umweltfreundliche Stromerzeugung gefördert, sondern auch die Wirtschaftlichkeit von Photovoltaikanlagen verbessert werden.

- Niedrige Modulproduktionskosten: Ein weiteres zentrales Ziel bestand darin, mittels flexibler, hochautomatisierter Verbundproduktion niedrige Modulproduktionskosten von unter 40 Cent pro Wattpeak zu erreichen. Dabei sollten nicht nur die Personalkosten reduziert, sondern auch höchste Produktionsqualität, erhebliche Energie- und Materialeinsparungen sowie flexible Produktspezifikationen realisiert werden.

- Entwicklung neuer Produktionsmaschinen: Ein innovatives Ziel war die Entwicklung einer neuen Generation von PECVD- und PVD-Maschinen mit beeindruckenden Wafer-Durchsatzraten von mehr als 4.000 Wafern pro Stunde. Gleichzeitig war vorgesehen, diese Maschinen nahtlos in Industrie 4.0-Konzepte zu integrieren, um eine hochmoderne, vernetzte Produktionsumgebung zu schaffen.

Um die hochgesteckten Ziele des Projektes "Wafer 4.0" zu erreichen, lag der Schwerpunkt der Arbeit der Kontron AIS auf der Etablierung eines effizienten Workflows zur Erfassung, Bereinigung und Auswertung von Maschinendaten. Die zentrale Herausforderung dabei: die Entwicklung einer nahtlosen Integrationsschicht, um die komplexen Produktionsdaten in der Digitalisierungslösung EquipmentCloud® zu speichern und gleichzeitig einen reibungslosen Zugriff für Auswertungszwecke zu ermöglichen.

Datenerfassung und -speicherung:

Kontron AIS implementierte eine fortgeschrittene Integrationsschicht, um Daten aus verschiedenen Quellen schnell und einfach zu sammeln. Diese Daten, seien es bereits vorhandene Produktionsdaten oder frisch von den Maschinen über deren Schnittstellen gewonnene Informationen, durchlaufen einen teilautomatisierten ETL-Prozess. Hier kamen insbesondere Verfahren aus dem Bereich Big Data zum Einsatz. Ziel dieser Daten ist die EquipmentCloud®, die nicht nur als Speicher dient, sondern auch eine umfassende Basis für zukünftige Analysen darstellt.

Datenanalyse und -optimierung:

Die gesammelten Daten bildeten die Grundlage für umfangreiche Analysen mit dem klaren Ziel, Zusammenhänge qualitativ und quantitativ zu identifizieren. Neben der klassischen Datenanalyse wurden auch fortgeschrittene Verfahren des maschinellen Lernens eingesetzt. Die daraus gewonnenen Erkenntnisse dienten auch der aktiven Optimierung des Produktionsprozesses. Das entwickelte Vorgehensmodell zur Identifikation von Korrelationen spielte dabei eine entscheidende Rolle. Es half, weitere Zusammenhänge zu entdecken und gleichzeitig die Analysezeit erheblich zu verkürzen.

Die Cloud als Datenverwaltungssystem

Immer fortschrittlichere und stärker vernetzte Maschinen erfordern, dass die erzeugten Daten effizient verwaltet werden. Unternehmen stehen daher vor der Herausforderung, riesige Mengen an Maschinendaten zu speichern, zu verarbeiten und in Echtzeit darauf zuzugreifen. Diese Aufgabe musste daher im Rahmen des Forschungsprojekts als Erstes angegangen werden. Als Fundament für die Datenverwaltung und als Dreh- und Angelpunkt nimmt die Digitalisierungslösung EquipmentCloud® eine bedeutende Rolle für den gesamten Lebenszyklus der Maschinen ein.

Von der Konzeption und Entwicklung bis zur Wartung und möglichen Außerbetriebnahme werden alle relevanten Daten erfasst und in der EquipmentCloud® gespeichert. Das ermöglicht nicht nur eine effiziente Überwachung des Maschinenzustands, sondern bildet auch die Grundlage für prädiktive Wartung und Optimierung von Betriebsabläufen.

- Filebasiertes Sammeln: Einfach und präzise

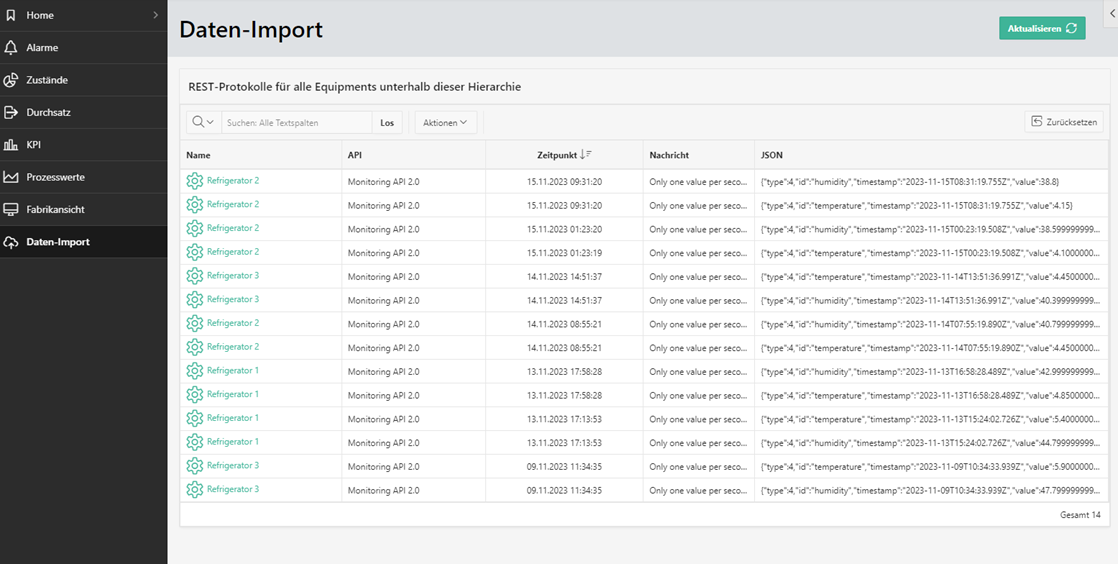

Bei diesem Ansatz werden Daten in vordefinierten Dateiformaten gesammelt und manuell in die EquipmentCloud® übertragen. Er ist besonders effizient, wenn Daten zu bestimmten Zeitpunkten gesammelt werden müssen und eine Echtzeitübertragung nicht erforderlich ist. Darüber hinaus minimiert diese Variante den technischen Aufwand erheblich und umgeht die üblichen Herausforderungen in der IT, die bei einer direkten Kopplung von Daten auftreten können. - REST-API: Sichere und dynamische Live-Kopplung

Die REST-API eröffnet neue Möglichkeiten für die Datenübertragung. Dieser fortschrittlicher Ansatz ermöglicht nicht nur eine dynamische Live-Kopplung zwischen den Anlagen und der Cloud, sondern auch Authentifizierungsmöglichkeiten über OAuth2.0 (Identity Service) – eine hochmoderne Sicherheitsmaßnahme. Zudem erlaubt die REST-API dank dem geschickten Einsatz von Bulk-Upload eine effiziente Übertragung großer Datenmengen. Die Vorteile der REST-API lassen sich in drei Punkten zusammenfassen:

- Echtzeit-Datenübertragung: In Branchen mit schnellen Reaktionsanforderungen ist die sofortige Reaktion auf aktuelle Ereignisse in der Anlage von unschätzbarem Wert.

- Authentifizierung mit OAuth2.0: Die Sicherheit von Daten hat höchste Priorität. Durch die fortschrittliche Authentifizierungsmethode mit OAuth2.0 wird eine zuverlässige und sichere Identifikation sichergestellt.

- Verwendung von Bulk-Upload: Vor allem in Umgebungen mit großen Datenmengen ist die Möglichkeit des Bulk-Uploads sehr effizient, um große Datenmengen ohne Leistungsverluste zu übertragen.

Insgesamt ermöglicht die EquipmentCloud® nicht nur die nahtlose Integration von Daten, sondern bildet auch eine flexible und leistungsstarke Grundlage für die effiziente Verwaltung von Maschinendaten in der Cloud. Die gesammelten und gespeicherten Daten dienen der Produktion als verlässliche Informationsbasis und werden in den nächsten Schritten weiterverwendet.

Datenmanagement im Fokus: Optimierung des ETL-Prozesses und der Cloud-Integration

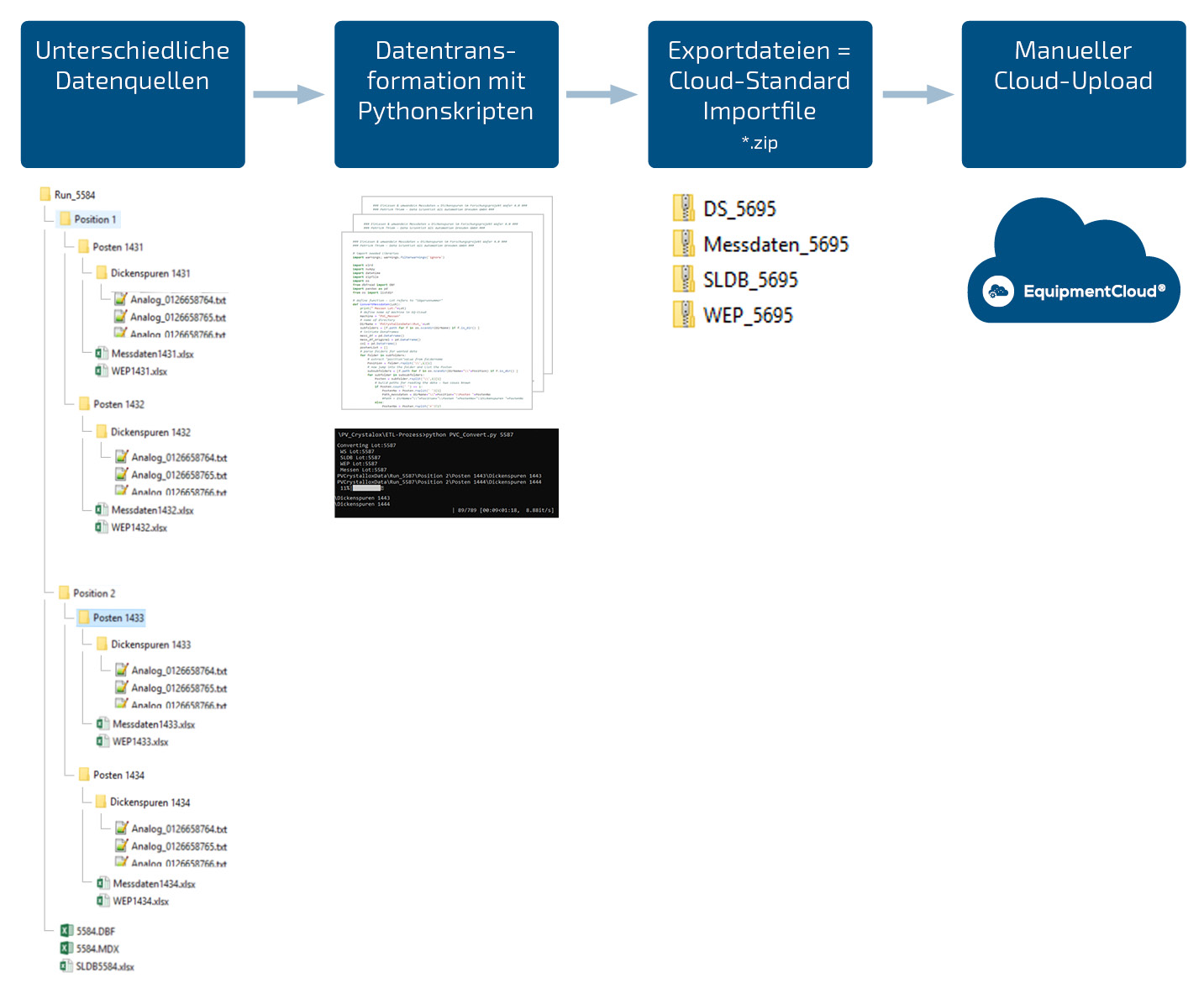

Ein wichtiger Teil des Projekts bestand in der umfassenden Aufbereitung und Bereitstellung der Messdaten für die EquipmentCloud®. Hierbei spielte ein teilautomatisierter ETL-Prozess eine zentrale Rolle, um sicherzustellen, dass die Daten optimal für weitere Analysen vorbereitet sind.

Ein Schritt des ETL-Prozesses war die Filterung und Reduktion der vorhandenen Daten. Mithilfe dieser Maßnahmen wurden nicht nur physikalisch unmögliche Werte eliminiert, sondern auch die Grundlage für präzise Analysen und nachfolgendes maschinelles Lernen geschaffen.

Der teilautomatisierte ETL-Prozess gliedert sich in drei Hauptphasen:

- Extraktion (extract): In dieser Phase wurden die Daten aus verschiedenen Quellen identifiziert und geladen. Dies bildete die Basis für den weiteren Verarbeitungsprozess.

- Transformation (transform): Die erhaltenen Daten wurden in ein einheitliches Zielformat gebracht, um sicherzustellen, dass alle Informationen in einer konsistenten Struktur vorliegen. Diese Homogenisierung war entscheidend für eine reibungslose und effektive Analyse.

- Laden (load): Die transformierten Daten wurden schließlich in die Zieldatenbank geladen, wo sie für die EquipmentCloud® zur Verfügung stehen. Dieser Schritt ermöglichte nicht nur die Speicherung der Daten, sondern legte auch den Grundstein für die Visualisierung in der Cloud.

Python-Modul für die Cloud-Integration

Um die Daten effektiv in die Cloud zu übertragen und sie dort anschaulich zu visualisieren, wurde ein spezielles Python-Modul entwickelt. Dieses Modul erleichtert nicht nur den Datentransfer, sondern schafft auch eine benutzerfreundliche Plattform für die EquipmentCloud®, um die Daten in Echtzeit zu überwachen und für Analysen nutzen zu können.

Die sorgfältige Aufbereitung und Bereitstellung der Messdaten schafft somit die Grundlage für präzise Analysen und ermöglicht der EquipmentCloud® den effizienten Zugriff auf entscheidende Informationen.

Für die Datenübertragung in die EquipmentCloud® wurden zwei differenzierte Schnittstellen entwickelt. Auf Backend-Seite wurde eine REST-Schnittstelle eingerichtet, die es ermöglicht, Prozess-, Status-, Alarm- und Ausbringungsmengenwerte abzufragen.

Die REST API-Schnittstelle liest Daten gemäß einer Anfrage aus der Datenbank aus und gibt sie als JSON-Daten zurück. Hierbei wird auf der Client-Seite die Basic Authentication genutzt, um die Rechte und Sichtbarkeiten zu prüfen und nur autorisierten Nutzern Zugriff zu gewähren.

Python-Modul „PyEqCloud“

Zusätzlich wurde für die Abfrage dieser Daten im Frontend ein offizielles Python-Modul namens „PyEqCloud“ entwickelt. Das Paket ermöglicht es, Daten in großem Umfang, performant und zuverlässig über die REST-Schnittstelle abzurufen. Der gesamte Netzwerkverkehr wird darüber abgewickelt, wodurch Daten an der Schnittstelle bereitgestellt und in Python-Formaten zurückgeliefert werden. Das Modul nutzt die vorhandene REST-Schnittstelle und ermöglicht die Integration anderer Analyse-Systeme, die ebenfalls die REST-Schnittstelle verwenden können. PyEqCloud wurde speziell für die Kommunikation zwischen der EquipmentCloud® und einer Python Entwicklungsumgebung entwickelt und bietet die Möglichkeit, in der weiteren Entwicklung leicht und schnell, um neue Funktionen erweitert zu werden. Das Modul erlaubt momentan die Abfrage von zeit- und materialbezogenen Prozess-, Alarm-, Status- sowie Ausbringungsdaten. Außerdem werden weitere Funktionen unterstützt, wie die Abfrage von Materialdaten oder die kontinuierliche Datenabfrage über einen Datenstrom.

Datenanalyse & prädiktive Systeme: Ermittlung potenzieller Korrelationen für das Training von Machine Learning Algorithmen

Nach dem umfangreichen Datensammeln im Projekt galt es, potenzielle Korrelationen in den Messdaten zu identifizieren. Durch den gezielten Einsatz von Machine-Learning-Algorithmen und künstlichen neuronalen Netzen soll das übergeordnete Ziel der Ermöglichung von Prozess- und Qualitätsoptimierung erreicht werden.

Die Forschung konzentrierte sich dabei stark darauf, bisher unbekannte Korrelationen mit Kausalzusammenhängen in den vorhandenen Daten aufzudecken. Explorative statistische Datenanalysen waren entscheidend, um tiefergehende Einblicke in Zusammenhänge zu gewinnen. Es sollten Machine-Learning-Modelle entwickelt werden, die nicht nur Datenmuster erkennen, sondern auch zu konkreten Optimierungen in Prozessen und Produktqualität beitragen können.

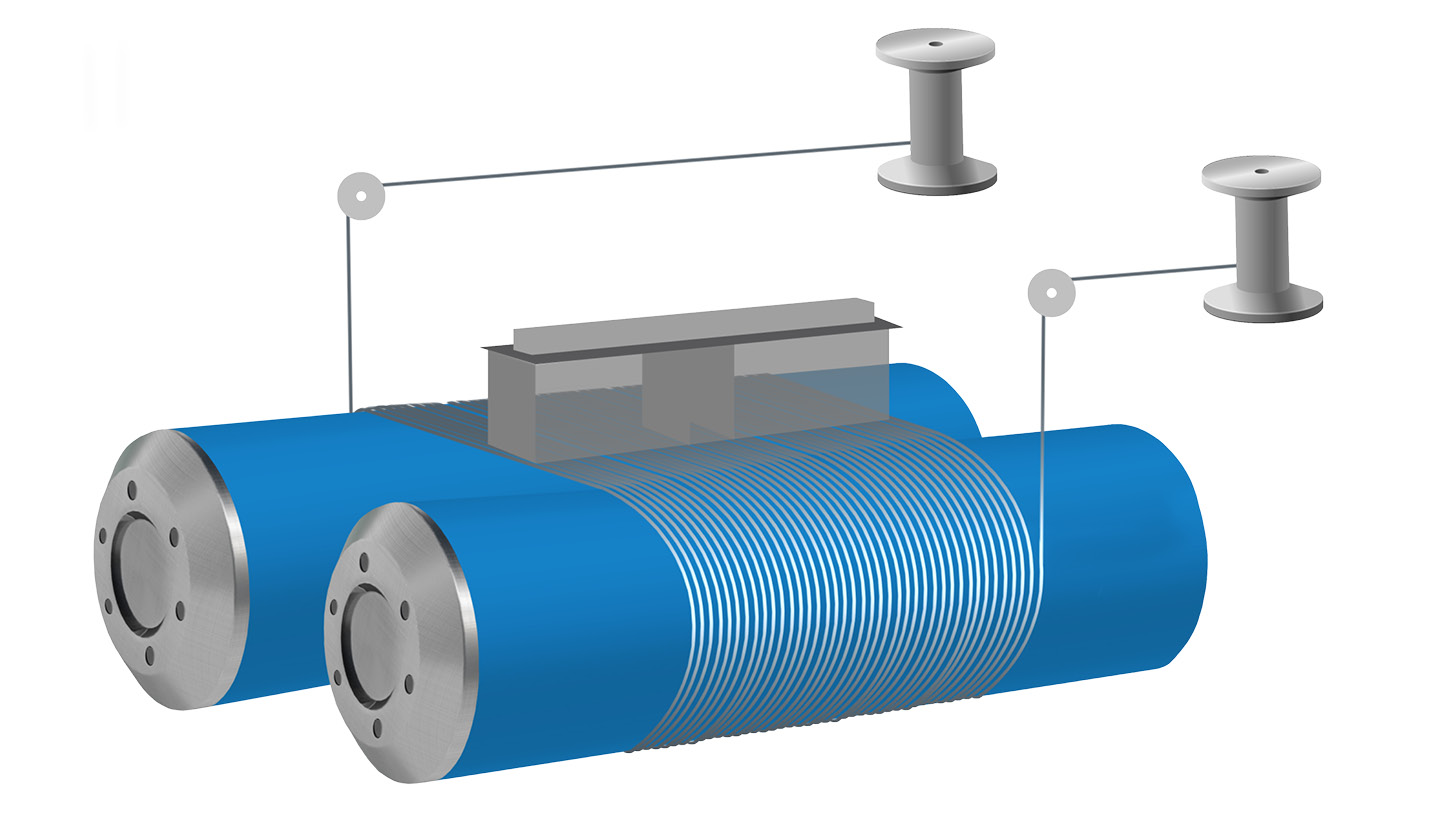

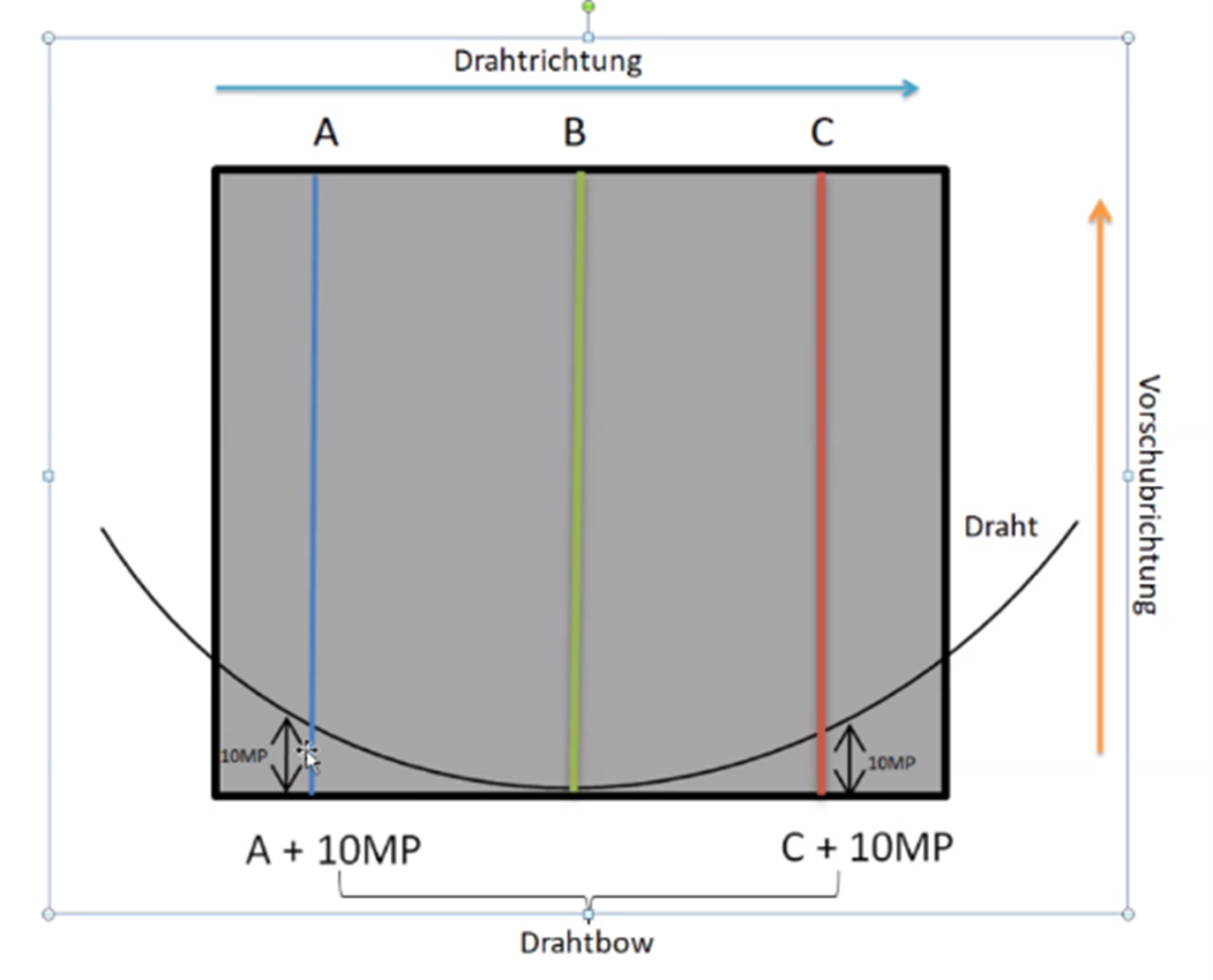

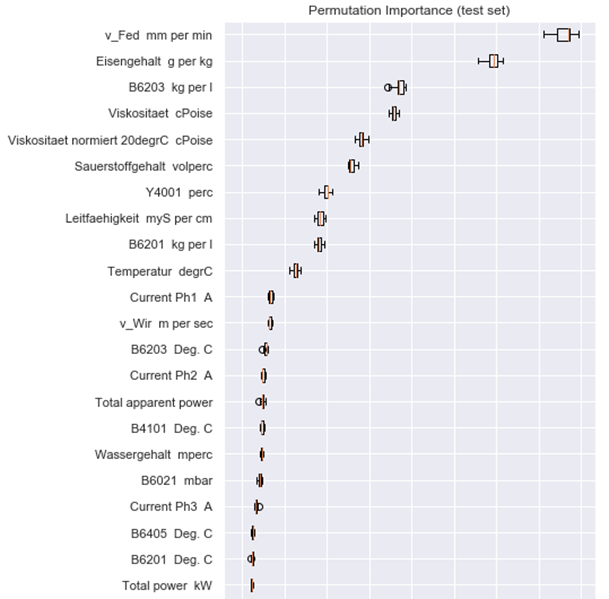

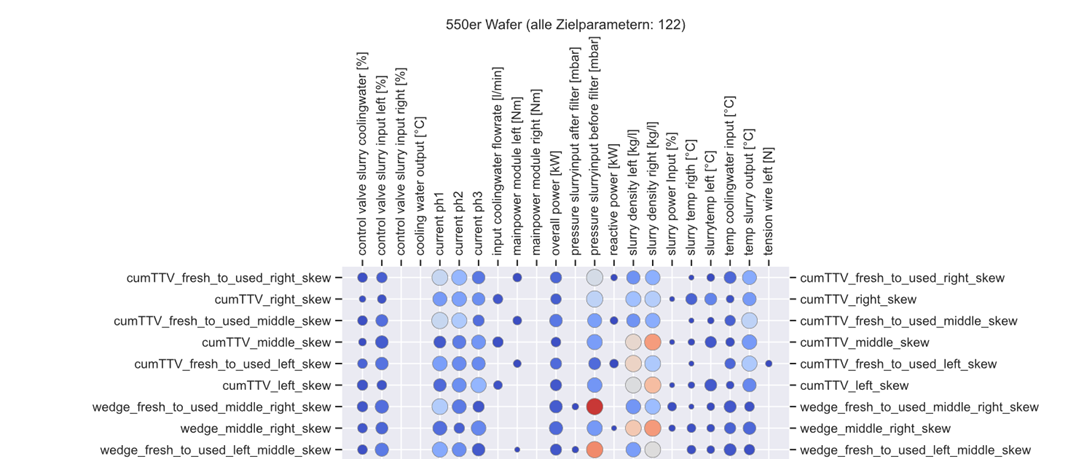

Ein Beispiel für die konkrete Anwendung dieses Ansatzes war die Untersuchung des Einflusses von Sägeparametern auf den Profilverlauf der Dickenspuren. Diese Dickenspuren entstehen beim Sägeprozess eines Siliziumblocks (siehe Abbildung 5) mithilfe einer Drahtsäge (siehe Abbildung 4). Dabei wurden Features (Merkmalsträger) der Dickenspuren analysiert und ein Machine Learning Modell, basierend auf dem Gradient Boosting Tree Algorithmus, erstellt, mit dem Ziel diese Features vorherzusagen.

Zunächst zeigte die Analyse, dass die anfangs identifizierten Korrelationen nicht ausreichend waren, um den tatsächlichen Einfluss der Sägeparameter auf den Verlauf der Dickenspuren zu untersuchen. Folglich wurden weitere Merkmale aus den Dickenspuren berechnet, um tiefgehender Erkenntnisse zu erlangen. In Abbildung 6 werden die Merkmale nach ihrer Wichtigkeit absteigend dargestellt (ermittelt auf einem Testdatensatz).

Da es eine Vielzahl von Merkmalen gab, wurden verschiedene Machine-Learning-Modelle sorgfältig überprüft. Diese Modelle wurden erstellt, um umfassend den komplexen Einfluss der Sägeparameter auf den Verlauf der Dickenspuren zu untersuchen. Die gewonnenen Erkenntnisse bilden schließlich die Grundlage für die Ableitung präziser Steuerungsinformationen. Diese Informationen ermöglichten eine gezielte Prozessoptimierung, die nicht nur auf theoretischen Annahmen, sondern auf fundierten Daten und Erkenntnissen basierte.

Blick in eine kristallklare Zukunft

Das Forschungsprojekt „Wafer4.0“ wurde erfolgreich abgeschlossen. Die gewonnen Erkenntnisse fließen auch in die Weiterentwicklung der EquipmentCloud® ein. So werden die REST-Schnittstellen kontinuierlich erweitert und das Monitoring-Modul optimiert, um Maschinendaten immer übersichtlicher und aussagekräftiger darzustellen. Das Python-Modul, das im Rahmen des Projekts entwickelt wurde und nun als Open-Source-Software verfügbar ist, spielt eine wichtige Rolle bei der vereinfachten Verarbeitung von Maschinendaten. Dadurch wird die Transparenz im Produktionsprozess erhöht.

Ziel des Projektes war die Stärkung des deutschen Maschinen- und Anlagenbaus. Durch die effiziente Nutzung von Daten und die Implementierung von fortschrittlichen Technologien leistete das Projekt einen Beitrag sowohl im produktiven als auch im informationstechnischen Bereich der Branche.

Die Einführung einer Integrationsebene hat den gesamten Produktionsablauf umfassend eingebettet und den Grundstein für ein selbstoptimierendes System gelegt. Durch die Implementierung des ETL-Prozesses und die gezielte Nutzung von Big-Data-Techniken konnte die Datenverarbeitung effizienter gestaltet werden, was zu verkürzten Prozesszeiten und Kosteneinsparungen führte.

Die systematische Optimierung und Analyse von Daten schuf eine intelligente Produktionsumgebung. Diese basiert nicht nur auf aktuellen Daten, sondern antizipiert auch zukünftige Entwicklungen proaktiv und reagiert darauf. Die Zusammenarbeit mit Projektpartnern betont die Bedeutung der Verknüpfung von industrieller Fertigung mit modernster Informationstechnologie. So wird die Zukunft selbstoptimierender Produktionsanlagen stetig weiter ausgebaut. Das Forschungsprojekt "Wafer 4.0" ist ein wesentlicher Impulsgeber für zukünftige Innovationen. Es symbolisiert die eindrucksvolle Fusion von traditionellen Produktionsprozessen mit dem Zeitalter von Industrie 4.0.